Qzone

Qzone

微博

微博

微信

微信

近日,一则报道出现在了各大主流媒体和科技自媒体的版面上:浙江大学联合之江实验室共同研制成功了我国首台基于自主知识产权类脑芯片的类脑计算机。

据介绍,这台类脑计算机包含792颗浙江大学研制的达尔文2代类脑芯片,支持1.2亿脉冲神经元、近千亿神经突触,与小鼠大脑神经元数量规模相当,典型运行功耗只需要350-500瓦,同时它也是目前国际上神经元规模最大的类脑计算机。

绝大多数人的注意力,以及绝大多数的新闻标题重点,都放在了“全球规模最大”的字样上。毕竟在国内科技产业备受国外打压的当下,这种消息就如透过乌云的一道阳光,特别耀眼。

不过遗憾的是,从市面上的新闻报道来看,浙大并没有公布很多这款新产品的有用信息,尤其是在许多很受关注的技术要点上语焉不详。

但是它给了许多人了解这项新技术——类脑计算机的机会。

什么是类脑计算机呢?顾名思义,就是像人脑一样的计算机。

当涉及到高速计算、逻辑推理和精确记忆时,人是要拜伏在计算机面前的。除了少数天赋异禀乃至可以到电视节目中公开展示才能的人,想必绝大多数人不敢说他们的计算能力超过电脑CPU,记忆能力超过电脑存储。

但问题在于,尽管计算机这么强大,但它们做到的只是“分析”和“记录”,它们无法像人类一样“感知”这个世界。

当我们透过双眼来看这个世界时,我们的大脑可以瞬间识别和感知所看到的事物。从根本上讲,人的大脑是一个可以传递内容和感知的“模式匹配”机器。就像当你看到某个人时,你知道他是小明,而不是老王,因为你能辨别出他的身高、面部表情、衣着和声音。

计算机“大脑”却无法做到这些。尽管它可以看到生活中的相同物体,也可以告诉你这是什么东西,但是它依靠的还是早先储存在它里面的数据,通过匹配数字模型来识别事物。

与此同时,人脑在处理信息方面的资源利用效率也更高。《自然》去年发表的长文《类脑智能与脉冲神经网络前沿》提到,人脑能够执行惊人的任务(例如同时识别多个目标、推理、控制和移动),而能量消耗只有接近2瓦左右。相比之下,标准计算机仅识别1000种不同的物体就需要消耗250瓦的能量。

要用目前最先进的计算机模拟人脑功能,功耗也高达800万瓦以上,速度比人脑要慢1000倍以上。

而人脑的功耗,目前尚没有准确的定论,但普遍认为在15W到40W左右。换到目前家用计算机上,这基本上只能是性能最烂的一档。

因此,出于现实对能够模拟人脑认知功能的计算需要,也出于本身对于了解人脑这个人体最复杂的系统的渴求,科学家们开始了对类脑计算机的研究。

对于类脑计算,首先要知道一点:人工智能并不是类脑计算。

人工智能常常和“人工神经网络”挂钩,这个词可能会让很多人联想到人的由1000亿个神经细胞互相连接形成的脑神经网络,再加上许多宣传中出现“模仿人脑”“自主学习”等词,在他们朴素的认知中,可能会将类脑计算和人工智能联系起来。

但是人工智能不是类脑计算。

尽管其灵感都是来源于人脑,但是从上世纪70年代演进至今的人工智能概念,本质上只是计算机学界对神经元研究的一次借鉴,主要是模仿了神经元分层处理的特征。它的基础还是坐落在统计学和控制论的概念上。

而类脑计算的本质是直接整体移植神经元系统,属于神经科学和仿生学范畴。

简单说,人工智能就是借鉴人脑,改进计算机技术,而类脑计算是用计算机技术再造一个人脑。

还要指出的一点是,现阶段的类脑计算并不算完全“类脑”,因为人类本身对大脑奥秘的认知都不完全,不了解智能背后的基本原理,所以不可能制造出具有“大脑智能”的类脑计算机呢?

关于这一点,也有人以此质疑发展类脑计算的可行性。不过,这是一种误解。尽管科学家还不了解大脑运作的原理,但现有技术已经足以了解大脑运作的方式。靠着对这种方式的了解,一样可以重塑一个大脑。

这就好像古人并不知道物质相互作用、分子变化释放化学能的机制,但他们简单地知道硝石、硫磺、木炭混在一起可以剧烈燃烧,靠着这一点就造出了烟花炮竹和早期的火器。同样道理,1903年莱特兄弟发明飞机之后,研究飞机为什么能上天的空气动力学才兴起。

人脑虽然是迄今已知的最为复杂的结构,拥有1000亿个神经元,每个神经元通过数千甚至上万个神经突触和其他神经元相连接,规模庞大,但仍然是一个复杂度有限的物理结构,通过科学手段是可以搞清楚的。

采用神经科学实验手段,从分子生物学和细胞生物学层次解析大脑神经元和突触的物理化学特性,理解神经元和突触的信号加工和信息处理特性,并无突破不了的技术障碍。

类脑计算技术路线总体上可分为3个层次:结构层次模仿脑,器件层次逼近脑,智能层次超越脑。

其中,“结构层次模仿脑”是像前面说的那样,从生理和物理层面把大脑剖析清楚,搞清楚其各单元、各模块之间的联系,以及这些联系负责的功能。

“器件层次逼近人脑”是指研制出模拟神经元和神经突触功能的器件,取代传统计算机的晶体管元件。

“智能层次超越脑”上升到系统和软件层面,是指开发出适合类脑计算的架构、算法和应用软件,对其进行培训等,使之最终产生智能。

开发完整的类脑计算机是一个体系化工程,其中涉及到方方面面的技术,1、2篇文章不可能论说详尽。因此本文就借着浙大研究的报道,说一说其中的关键技术。

从“包含792颗浙江大学研制的达尔文2代类脑芯片,支持1.2亿脉冲神经元、近千亿神经突触”等语句来看,他们已经突破了类脑计算发展的前2个层次,到达了“智能层次超越脑”的阶段。

虽然在新闻通稿中没有多少具体的东西,但还是提到了这个阶段的2项关键技术,一个是“1.2亿脉冲神经元”,另一个是浙江大学计算机学院教授潘纲在采访中提到的,“用硬件及软件模拟大脑神经网络的结构与运行机制,构造一种全新的人工智能系统”。

前者对应的是脉冲神经网络,后者对应的是非冯·诺依曼架构。

先说说后者——关于架构的问题。

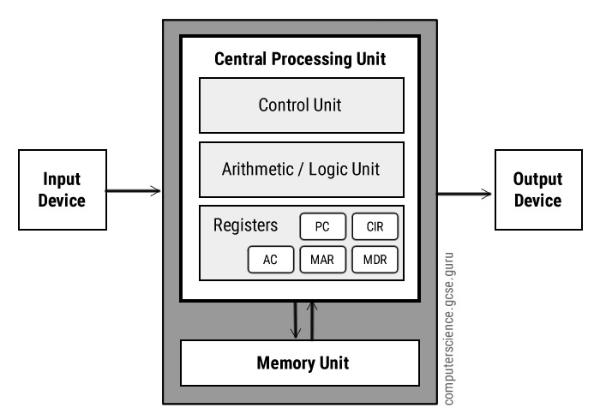

到目前为止,绝大多数试图仿真人类大脑的研究都集中在软件层面——这些软件最终的运算还是要由传统计算机用0和1来完成,本质上,它们依然没有摆脱传统计算机结构的束缚,也就是著名的“冯·诺依曼架构”。

1943年,美国陆军因为计算弹道的需要,委托宾夕法尼亚大学开发电子计算机,并于3年后得到成品——全球第1台通用电子计算机ENIAC。ENIAC每秒能进行5000次加法运算、400次的乘法运算。有了它之后,计算出1条弹道的时间从原来的20多分钟一下子缩短到了30秒。

不过,这台机器有一个致命缺陷——它是无法存储程序的。ENIAC的程序指令是存放在机器外部电路里的。需要计算某个题目时,必须先让程序员找到电路,接通数百条线路,需要耗费几十人几天的劳动,才可进行几分钟运算。

面对这个难题,1945年,“计算机之父”冯·诺依曼在著名的“101页报告”中革命性地提出了“存储程序”概念。

其原理是把程序本身当作数据来对待,将之一同存储在存储器中,按照指令驱动。

计算与内存是分离的单元:计算单元根据从内存中读取数据,计算完成后存回内存。这种“存储程序”体系架构被称为“冯·诺依曼架构”。一直到今天计算机已经发展了5代,我们的电脑依然是“冯•诺依曼架构”的。

但随着技术发展,这种结构的缺点开始暴露。

数据的存储和处理分开进行,处理器和内存各自做自己的工作。而根据摩尔定律,计算单元的性能随着晶体管特征尺寸的缩小而直接提升;后来主流的DRAM内存从晶体管尺寸缩小所获得的益处并不大,这就使得内存性能提升速度远远慢于处理器速度。

目前DRAM的性能已经成为了整体计算机性能的一个重要瓶颈,即所谓阻碍性能提升的“内存墙”。

内存墙对于处理器的限制是多方面的,不仅仅是限制了其计算性能,同时也是能效比的瓶颈。

众所周知,人工智能中神经网络模型的一个重要特点就是计算量大,而且计算过程中涉及到的数据量也很大。在AI芯片追求极致计算能效比的今天,内存墙对于AI芯片能效比的限制效应尤其显著。

目前,许多计算机科学家已经在研究非冯·诺依曼架构,而类脑计算天然就是其中一种。因为在人脑里,计算和存储是一体的,无论是计算还是存储,都是由神经元和突触的互动完成的。而神经元和突触是物理相连的,所以每个神经元计算都是本地的,而且从全局来看神经元们是分布式在工作。

从报道来看,浙大在这方面已经有了一定成果。

再说说脉冲神经网络。

前面说到,过去的神经网络虽然号称是模仿大脑神经系统,但本质上还是一些计算系统。最早的神经网络某种二极管或逻辑门电路。

一定的值输入进来,神经元汇集加和后,如何这个和的总量大于一个阈值,神经元就放电,小于一个阈值,神经元就不放电。无数这样的神经元连接起来,就构成了所谓的人工神经网络(ANN)。

然而事实上,这个架构与真正的生物神经网络相差极远。从根本上说,其差别在于数据传递的方式和内容。

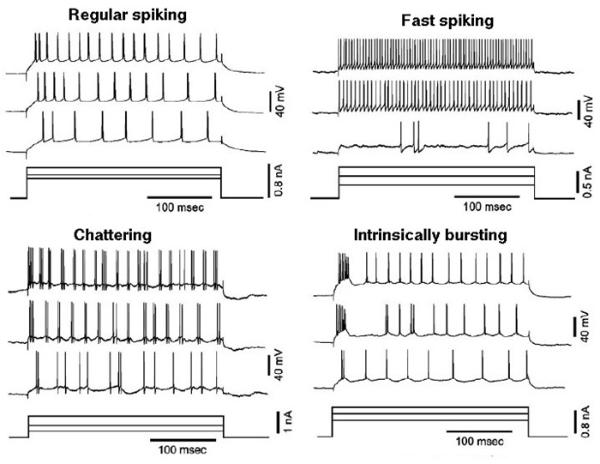

在人脑中,一个电信号首先通过轴突并激活突触,这些被激活的突触释放神经递质,快速到达神经元。神经元的膜电势开始升高,达到了放电阈值,神经元便会产生一个脉冲,传递给下一个神经元。但是如果没有新的输入,这些神经递质带来的兴奋性也会随着时间衰减。

可以看出,相较人工神经元,大脑中的神经元并不会传递一个数值,而是更类似于二进制——到达阈值就输出“1”,没到就输出“0”。

同时,大脑神经元传递信息还多出了一个因素——时间。和ANN里的神经元输入数值、计算、输出不同,大脑神经元还有一个膜电势积累和消散的过程。这种带有时间因素的二进制信息传递法,就是脉冲。

而脉冲神经网络的原理,简单来说,就是用一个考虑了时间因素的函数模拟膜电势随时间积累和消散,并最终输出结果的过程。

这有什么好处呢?这使得除了神经元发出的脉冲以外,信息传递的时间也成了信息的一部分,这样很多原本需要计算的信息,可以通过时间——包括脉冲的频率、时延等——进行传递。

(脉冲可以有不同频率)

这样,科学家就可能用更少的脉冲编码更多的信息,一个脉冲神经元可以取代传统神经网络中几百个神经元,这无疑对用最少的神经元放电得到更多的信息大有帮助。与此同时,在脉冲神经网络中,并非每个神经元都要进行计算,部分神经元在没接受到脉冲输入时,将不会工作。这些都使其具有很高的能源利用效率。

需要注意的是,关于以上脉冲神经网络原理的介绍,是为避免过多专业性内容显得枯燥,经过极度简化和通俗化的版本。关于其复杂的设计和计算内容,有兴趣的读者可以自行搜索相关信息及研究。

不可否认,“全球规模最大”的类脑计算机确实是一个进步。毕竟所有新技术体系的发展,除了某些情况下灵光一现带来的飞跃进步,也需要靠小小的东西积累起来。

本文来源前瞻网,转载请注明来源。本文内容仅代表作者个人观点,本站只提供参考并不构成任何投资及应用建议。(若存在内容、版权或其它问题,请联系:service@qianzhan.com)