Qzone

Qzone

微博

微博

微信

微信

11月14日 硅谷正在向AI数据中心投入数万亿美元,在巨额资本的刺激下,芯片制造商加速创新,其中网络连接技术成为创新重点,该技术用来连接芯片与芯片、服务器机架与服务器机架。

自计算机诞生以来,网络技术一直都是IT产业的核心,它至关重要,连接大型主机,实现数据共享。在半导体领域,网络技术几乎渗透到技术栈的各个层面——从芯片内部晶体管互连到芯片盒和机架之间的外部连接,全都有网络技术的身影。

在网络领域,华为、英伟达、博通、迈威(Marvell)拥有扎实技术。现在AI时代来临,企业开始推出新的网络解决方案,目标是加快数据传输速度。所以最近几年,我们看到Lightmatter、Celestial AI、PsiQuantum等新锐公司开始占据一席之地,它们借助光学技术提高计算效率。

光学技术(又称光子学)已经走到了发展的关键节点。PsiQuantum联合创始人兼首席科学官皮特·沙德博尔特(Pete Shadbolt)表示,25年来,人们一直认为光学技术枯燥乏味、昂贵、缺少实际用途,但AI照亮了光子学的前进道路。

一些风险投资家认为,传统电子互连技术无法满足AI高带宽要求,所以他们积极寻找可以提高数据吞吐量的创新方案。

英伟达提前布局,初创企业各展所长

Creative Strategies首席执行官本·巴贾林(Ben Bajarin)表示:“回顾历史,网络领域的报道一直非常枯燥,因为它的核心就是数据包交换;受到AI的驱动,网络需要承载相当庞大的工作负载,这也是最近速度相关创新层出不穷的原因。”

巴贾林认为,英伟达有先见之明,多年前它就完成了两笔关键收购,开始布局网络领域。

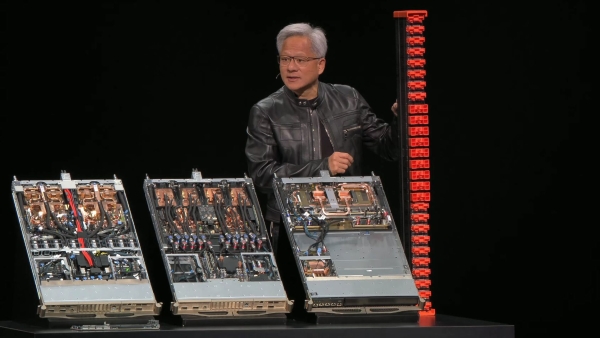

2020年,英伟达以70亿美元收购以色列迈络思科技(Mellanox Technologies),该公司专为服务器、数据中心提供高速网络解决方案。不久之后,英伟达又收购Cumulus Networks,该公司为Linux计算机网络软件系统提供支持。当时英伟达已经感知到,当GPU凭借其并行计算能力与其他GPU结合,部署于数据中心,它的性能会更上层楼。

Lightmatter致力于研究光子芯片技术,公司首席执行官尼克·哈里斯(Nick Harris)指出,AI需要的算力每三个月翻一番,计算机芯片尺寸在不断扩大,当芯片发展到一定程度,如果想继续提升性能,必然依赖芯片之间的连接技术。

硅光子学技术是一条可行路径,Lightmatter宣称自己打造了全球最快的AI芯片光子引擎,从本质上讲,就是通过光互联技术连接的3D硅堆叠结构。目前Lightmatter已经获得5亿美元投资,估值达44亿美元。

哈里斯(Nick Harris)认为:“计算的未来确实与光息息相关,电子技术肯定会继续存在,软件也是不可或缺的关键部分,但在当前的计算规模下,我们需要新思路,光技术正是计算机新前沿的重要组成部分。”

初创公司Celestial AI主攻光学互联技术,它于今年早些时候融资2.5亿美元;光量子计算机开发商PsiQuantum今年9月融资10亿美元,估值达70亿美元。

目前光学网络技术仍面临挑战,比如成本过高,需要高度专业的设备,而且产业还要求它必须兼容电子系统。

不论未来是电子技术取胜,还是光子技术占据上风,或者二者兼而有之,网络都会是核心。

中外企业竞逐网络技术创新

在AI发展过程中,英伟达成为GPU技术垂直整合商,博通则提供定制芯片、加速器及高速网络技术。博通目前的市值高达1.7万亿美元,与谷歌、Meta、OpenAI都有合作,它向合作伙伴提供数据中心芯片。

在光子学领域,博通也处于前沿位置。上个月,有报道称博通准备推出名为Thor Ultra的新型网络芯片,它可以让AI系统与数据中心其他部分实现高速连接。

还有很多企业也在向网络技术下注。例如,安谋(ARM)以2.65亿美元收购网络公司DreamBig。在财报会议上,安谋首席执行官勒内·哈斯(Rene Haas)宣称DreamBig对横向扩展和纵向扩展网络至关重要,也就是说它的技术可以让单个芯片集群在内部实现连接、高速传输数据,这与芯片机架之间的连接有所不同。

在国内,华为推出的大规模超节点互联技术走的也是相同路径。当AI集群规模达到数万乃至数十万张卡时,节点间的通信效率会急剧下降,华为“超节点”技术可以解决这一问题。

诺基亚前数据中心副总裁迈克·布什翁(Mike Bushong)认为:“更强大、更先进的AI离不开计算能力,而且是海量的计算能力。如今,每部署1兆瓦数据中心容量,网络相关支出的成本排在第二位,仅次于AI系统本身。”

生成式AI模型依赖跨节点、跨机架的实时信息共享,如果说GPU是脑细胞,网络就是神经系统,它通过信号传递将所有脑细胞连接起来。

存储即服务提供商Zadara的首席执行官约拉姆·诺维克(Yoram Novick)警告称:“如果不能确保拥有充足的互连带宽,仅仅简单增强GPU性能,可能会导致收益递减。”

目前的AI网络主要围绕以太网(Ethernet)、无限带宽技术(InfiniBand)、NVLink和超加速器链路(UALink)展开。以太网和无限带宽技术用于连接多台服务器,后者因为拥有超低延迟和更高带宽,是AI训练场景的首选方案。但在不久的将来,预计以太网技术将成为主导。

彭博情报(Bloomberg Intelligence)分析师称,目前训练环节约占数据中心支出的60%,预计到2032年更多资源将向推理倾斜,训练环节占比将降至20%。随着推理需求增长,工作负载将更多实现跨数据中心部署,届时高速网络将会变得更为重要。

总之,AI基础设施新时代已经到来,效率不仅由计算速度定义,网络性能同样关键,这是必然的发展趋势,大家须引起注意。

【以上内容转自“极客网”,不代表本网站观点。如需转载请取得极客网许可,如有侵权请联系删除。】

延伸阅读:

TOM2025-11-14 13:1211-14 13:12

TOM2025-11-14 13:1111-14 13:11

TOM2025-11-14 13:1011-14 13:10

TOM2025-11-14 13:1011-14 13:10